mirror of

https://github.com/huggingface/transformers.git

synced 2025-07-12 17:20:03 +06:00

* Just import torch AdamW instead * Update docs too * Make AdamW undocumented * make fixup * Add a basic wrapper class * Add it back to the docs * Just remove AdamW entirely * Remove some AdamW references * Drop AdamW from the public init * make fix-copies * Cleanup some references * make fixup * Delete lots of transformers.AdamW references * Remove extra references to adamw_hf

2.3 KiB

2.3 KiB

Optimization

.optimization モジュールは以下を提供します。

- モデルの微調整に使用できる重み減衰が修正されたオプティマイザー、および

_LRScheduleから継承するスケジュール オブジェクトの形式のいくつかのスケジュール:- 複数のバッチの勾配を累積するための勾配累積クラス

AdaFactor (PyTorch)

autodoc Adafactor

AdamWeightDecay (TensorFlow)

autodoc AdamWeightDecay

autodoc create_optimizer

Schedules

Learning Rate Schedules (Pytorch)

autodoc SchedulerType

autodoc get_scheduler

autodoc get_constant_schedule

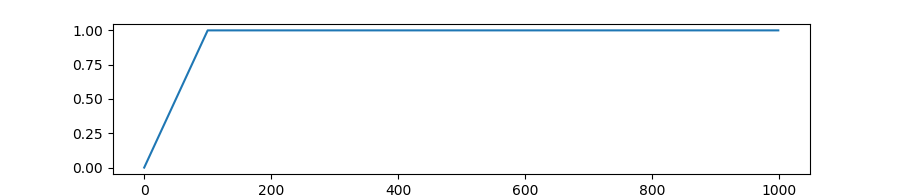

autodoc get_constant_schedule_with_warmup

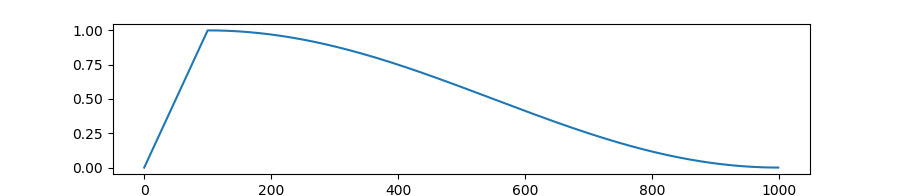

autodoc get_cosine_schedule_with_warmup

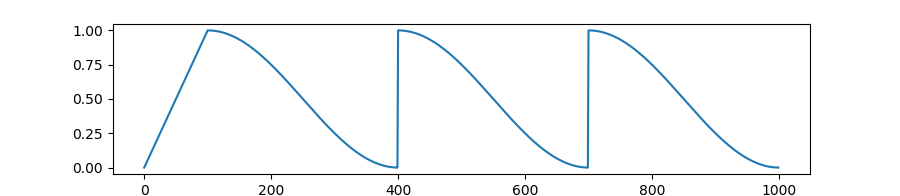

autodoc get_cosine_with_hard_restarts_schedule_with_warmup

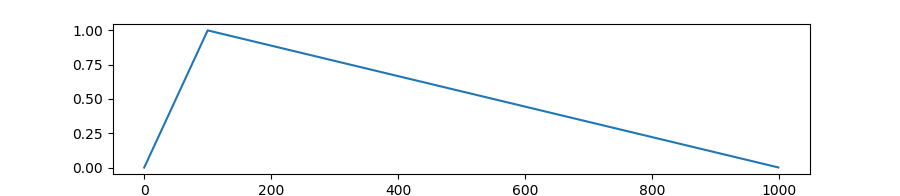

autodoc get_linear_schedule_with_warmup

autodoc get_polynomial_decay_schedule_with_warmup

autodoc get_inverse_sqrt_schedule

Warmup (TensorFlow)

autodoc WarmUp

Gradient Strategies

GradientAccumulator (TensorFlow)

autodoc GradientAccumulator