mirror of

https://github.com/huggingface/transformers.git

synced 2025-08-02 11:11:05 +06:00

[i18n-<languageCode>] Translating agents.md to Chinese (#35139)

* add "translate agents.md" * add "agents.md" * add "translate warnings" * add "totree" * add "remove transformer_agent" * add "remove transformer _agent file" --------- Co-authored-by: Steven Liu <59462357+stevhliu@users.noreply.github.com>

This commit is contained in:

parent

e8508924fd

commit

10feacd88a

@ -23,8 +23,8 @@

|

||||

title: 使用🤗 PEFT加载和训练adapters

|

||||

- local: model_sharing

|

||||

title: 分享您的模型

|

||||

- local: transformers_agents

|

||||

title: agents教程

|

||||

- local: agents

|

||||

title: 智能体和工具

|

||||

- local: llm_tutorial

|

||||

title: 使用LLMs进行生成

|

||||

title: 教程

|

||||

@ -102,7 +102,7 @@

|

||||

- sections:

|

||||

- sections:

|

||||

- local: main_classes/agent

|

||||

title: Agents和工具

|

||||

title: 智能体和工具

|

||||

- local: main_classes/callback

|

||||

title: Callbacks

|

||||

- local: main_classes/configuration

|

||||

|

||||

427

docs/source/zh/agents.md

Normal file

427

docs/source/zh/agents.md

Normal file

@ -0,0 +1,427 @@

|

||||

<!--Copyright 2024 The HuggingFace Team. All rights reserved.

|

||||

|

||||

Licensed under the Apache License, Version 2.0 (the "License"); you may not use this file except in compliance with

|

||||

the License. You may obtain a copy of the License at

|

||||

|

||||

http://www.apache.org/licenses/LICENSE-2.0

|

||||

|

||||

Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on

|

||||

an "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the

|

||||

specific language governing permissions and limitations under the License.

|

||||

|

||||

⚠️ Note that this file is in Markdown but contain specific syntax for our doc-builder (similar to MDX) that may not be

|

||||

rendered properly in your Markdown viewer.

|

||||

|

||||

-->

|

||||

# 智能体和工具

|

||||

|

||||

[[在colab里打开]]

|

||||

|

||||

### 什么是智能体 (Agent)?

|

||||

|

||||

大型语言模型(LLM)经过 [因果语言建模训练](./tasks/language_modeling) 可以应对各种任务,但在一些基本任务(如逻辑推理、计算和搜索)上常常表现不佳。当它们被用在自己不擅长的领域时,往往无法生成我们期望的答案。

|

||||

|

||||

为了解决这个问题,可以创建**智能体**.

|

||||

|

||||

智能体是一个系统,它使用 LLM 作为引擎,并且能够访问称为**工具**的功能。

|

||||

|

||||

这些**工具**是执行任务的函数,包含所有必要的描述信息,帮助智能体正确使用它们。

|

||||

|

||||

智能体可以被编程为:

|

||||

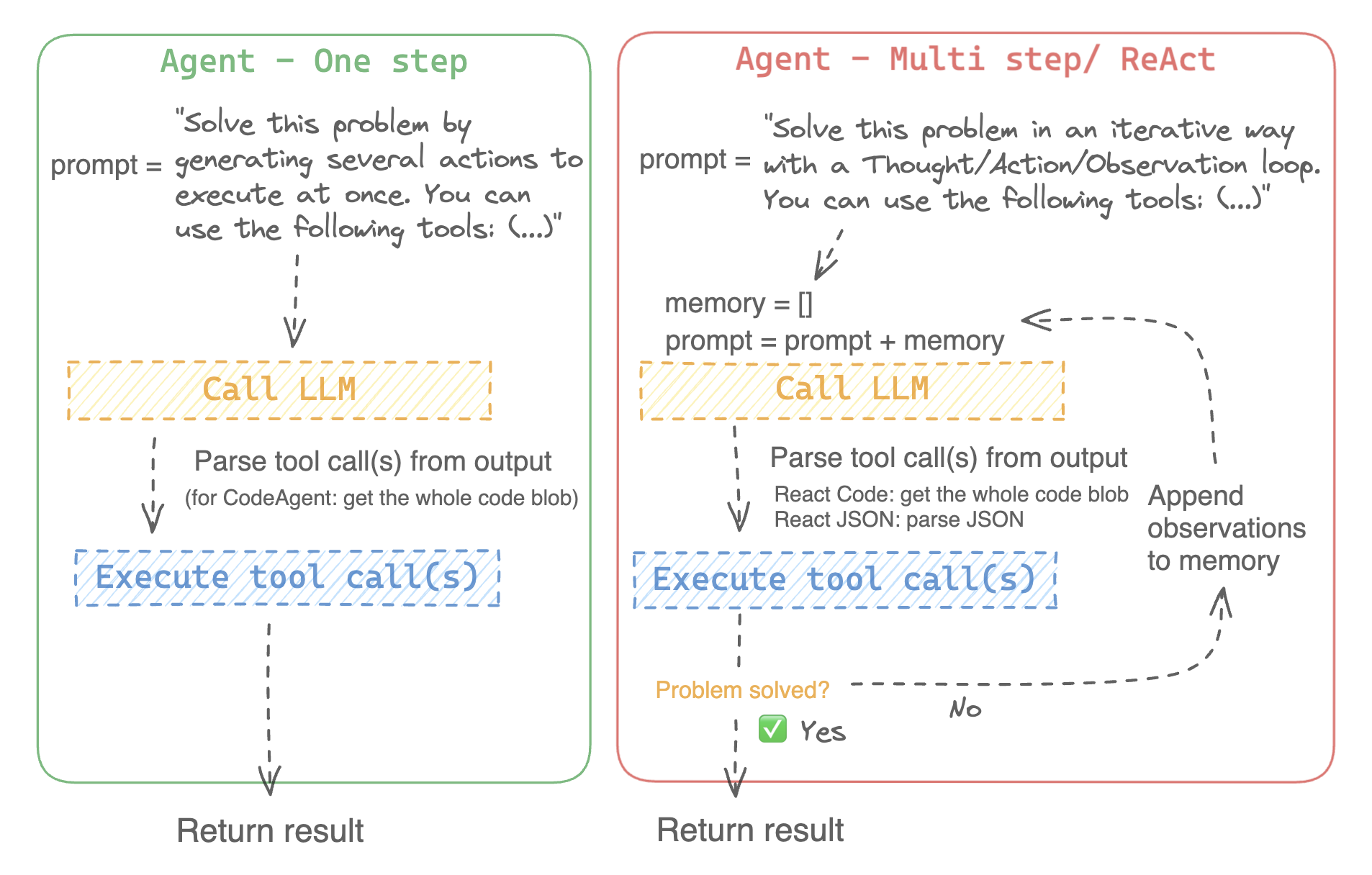

- 一次性设计一系列工具并同时执行它们,像 [`CodeAgent`]

|

||||

- 一次执行一个工具,并等待每个工具的结果后再启动下一个,像 [`ReactJsonAgent`]

|

||||

|

||||

### 智能体类型

|

||||

|

||||

#### 代码智能体

|

||||

|

||||

此智能体包含一个规划步骤,然后生成 Python 代码一次性执行所有任务。它原生支持处理不同输入和输出类型,因此推荐用于多模态任务。

|

||||

|

||||

#### 推理智能体

|

||||

|

||||

这是解决推理任务的首选代理,因为 ReAct 框架 ([Yao et al., 2022](https://huggingface.co/papers/2210.03629)) 使其在基于之前观察进行推理时非常高效。

|

||||

|

||||

我们实现了两种版本的 ReactJsonAgent:

|

||||

- [`ReactJsonAgent`] 将工具调用作为 JSON 格式输出。

|

||||

- [`ReactCodeAgent`] 是 ReactJsonAgent 的一种新型,生成工具调用的代码块,对于具备强大编程能力的 LLM 非常适用。

|

||||

|

||||

> [TIP]

|

||||

> 阅读 [Open-source LLMs as LangChain Agents](https://huggingface.co/blog/open-source-llms-as-agents) 博文,了解更多关于推理智能体的信息。

|

||||

|

||||

<div class="flex justify-center">

|

||||

<img

|

||||

class="block dark:hidden"

|

||||

src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/Agent_ManimCE.gif"

|

||||

/>

|

||||

<img

|

||||

class="hidden dark:block"

|

||||

src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/Agent_ManimCE.gif"

|

||||

/>

|

||||

</div>

|

||||

|

||||

|

||||

|

||||

以下是一个推理代码智能体如何处理以下问题的示例:

|

||||

|

||||

```py3

|

||||

>>> agent.run(

|

||||

... "How many more blocks (also denoted as layers) in BERT base encoder than the encoder from the architecture proposed in Attention is All You Need?",

|

||||

... )

|

||||

=====New task=====

|

||||

How many more blocks (also denoted as layers) in BERT base encoder than the encoder from the architecture proposed in Attention is All You Need?

|

||||

====Agent is executing the code below:

|

||||

bert_blocks = search(query="number of blocks in BERT base encoder")

|

||||

print("BERT blocks:", bert_blocks)

|

||||

====

|

||||

Print outputs:

|

||||

BERT blocks: twelve encoder blocks

|

||||

|

||||

====Agent is executing the code below:

|

||||

attention_layer = search(query="number of layers in Attention is All You Need")

|

||||

print("Attention layers:", attention_layer)

|

||||

====

|

||||

Print outputs:

|

||||

Attention layers: Encoder: The encoder is composed of a stack of N = 6 identical layers. Each layer has two sub-layers. The first is a multi-head self-attention mechanism, and the second is a simple, position- 2 Page 3 Figure 1: The Transformer - model architecture.

|

||||

|

||||

====Agent is executing the code below:

|

||||

bert_blocks = 12

|

||||

attention_layers = 6

|

||||

diff = bert_blocks - attention_layers

|

||||

print("Difference in blocks:", diff)

|

||||

final_answer(diff)

|

||||

====

|

||||

|

||||

Print outputs:

|

||||

Difference in blocks: 6

|

||||

|

||||

Final answer: 6

|

||||

```

|

||||

|

||||

### 如何构建智能体?

|

||||

|

||||

要初始化一个智能体,您需要以下参数:

|

||||

|

||||

- **一个 LLM** 来驱动智能体——智能体本身并不是 LLM,而是一个使用 LLM 作为引擎的程序。

|

||||

- **一个系统提示**:告诉 LLM 引擎应该如何生成输出。

|

||||

- **一个工具箱**,智能体可以从中选择工具执行。

|

||||

- **一个解析器**,从 LLM 输出中提取出哪些工具需要调用,以及使用哪些参数。

|

||||

|

||||

在智能体系统初始化时,工具属性将生成工具描述,并嵌入到智能体的系统提示中,告知智能体可以使用哪些工具,并且为什么使用它们。

|

||||

|

||||

**安装依赖**

|

||||

|

||||

首先,您需要安装**智能体**所需的额外依赖:

|

||||

|

||||

```bash

|

||||

pip install transformers[agents]

|

||||

```

|

||||

**创建LLM引擎**

|

||||

|

||||

定义一个 `llm_engine` 方法,该方法接受一系列[消息](./chat_templating)并返回文本。该 `callable` 还需要接受一个 `stop` 参数,用于指示何时停止生成输出。

|

||||

|

||||

```python

|

||||

from huggingface_hub import login, InferenceClient

|

||||

|

||||

login("<YOUR_HUGGINGFACEHUB_API_TOKEN>")

|

||||

|

||||

client = InferenceClient(model="meta-llama/Meta-Llama-3-70B-Instruct")

|

||||

|

||||

def llm_engine(messages, stop_sequences=["Task"]) -> str:

|

||||

response = client.chat_completion(messages, stop=stop_sequences, max_tokens=1000)

|

||||

answer = response.choices[0].message.content

|

||||

return answer

|

||||

```

|

||||

|

||||

您可以使用任何符合以下要求的 `llm_engine` 方法:

|

||||

1. [输入格式](./chat_templating)为 (`List[Dict[str, str]]`),并且返回一个字符串。

|

||||

2. 它在 `stop_sequences` 参数传递的序列处停止生成输出。

|

||||

|

||||

此外,`llm_engine` 还可以接受一个 `grammar` 参数。如果在智能体初始化时指定了 `grammar`,则该参数将传递给 `llm_engine` 的调用,以允许[受限生成](https://huggingface.co/docs/text-generation-inference/conceptual/guidance),以强制生成格式正确的智能体输出。

|

||||

|

||||

您还需要一个 `tools` 参数,它接受一个 `Tools` 列表 —— 可以是空列表。您也可以通过定义可选参数 `add_base_tools=True` 来将默认工具箱添加到工具列表中。

|

||||

|

||||

现在,您可以创建一个智能体,例如 [`CodeAgent`],并运行它。您还可以创建一个 [`TransformersEngine`],使用 `transformers` 在本地机器上运行预初始化的推理管道。 为了方便起见,由于智能体行为通常需要更强大的模型,例如 `Llama-3.1-70B-Instruct`,它们目前较难在本地运行,我们还提供了 [`HfApiEngine`] 类,它在底层初始化了一个 `huggingface_hub.InferenceClient`。

|

||||

|

||||

```python

|

||||

from transformers import CodeAgent, HfApiEngine

|

||||

|

||||

llm_engine = HfApiEngine(model="meta-llama/Meta-Llama-3-70B-Instruct")

|

||||

agent = CodeAgent(tools=[], llm_engine=llm_engine, add_base_tools=True)

|

||||

|

||||

agent.run(

|

||||

"Could you translate this sentence from French, say it out loud and return the audio.",

|

||||

sentence="Où est la boulangerie la plus proche?",

|

||||

)

|

||||

```

|

||||

|

||||

当你急需某个东西时这将会很有用!

|

||||

您甚至可以将 `llm_engine` 参数留空,默认情况下会创建一个 [`HfApiEngine`]。

|

||||

|

||||

```python

|

||||

from transformers import CodeAgent

|

||||

|

||||

agent = CodeAgent(tools=[], add_base_tools=True)

|

||||

|

||||

agent.run(

|

||||

"Could you translate this sentence from French, say it out loud and give me the audio.",

|

||||

sentence="Où est la boulangerie la plus proche?",

|

||||

)

|

||||

```

|

||||

|

||||

请注意,我们使用了额外的 `sentence` 参数:您可以将文本作为附加参数传递给模型。

|

||||

|

||||

您还可以使用这个来指定本地或远程文件的路径供模型使用:

|

||||

|

||||

```py

|

||||

from transformers import ReactCodeAgent

|

||||

|

||||

agent = ReactCodeAgent(tools=[], llm_engine=llm_engine, add_base_tools=True)

|

||||

|

||||

agent.run("Why does Mike not know many people in New York?", audio="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/recording.mp3")

|

||||

```

|

||||

|

||||

系统提示和输出解析器会自动定义,但您可以通过调用智能体的 `system_prompt_template` 来轻松查看它们。

|

||||

|

||||

```python

|

||||

print(agent.system_prompt_template)

|

||||

```

|

||||

|

||||

尽可能清楚地解释您要执行的任务非常重要。 每次 [`~Agent.run`] 操作都是独立的,并且由于智能体是由 LLM 驱动的,提示中的细微变化可能会导致完全不同的结果。

|

||||

您还可以连续运行多个任务,每次都会重新初始化智能体的 `agent.task` 和 `agent.logs` 属性。

|

||||

|

||||

|

||||

#### 代码执行

|

||||

|

||||

Python 解释器在一组输入和工具上执行代码。 这应该是安全的,因为只能调用您提供的工具(特别是 Hugging Face 的工具)和 print 函数,因此您已经限制了可以执行的操作。

|

||||

|

||||

Python 解释器默认不允许导入不在安全列表中的模块,因此大多数明显的攻击问题应该不成问题。 您仍然可以通过在 [`ReactCodeAgent`] 或 [`CodeAgent`] 初始化时通过 `additional_authorized_imports` 参数传递一个授权的模块列表来授权额外的导入:

|

||||

|

||||

```py

|

||||

>>> from transformers import ReactCodeAgent

|

||||

|

||||

>>> agent = ReactCodeAgent(tools=[], additional_authorized_imports=['requests', 'bs4'])

|

||||

>>> agent.run("Could you get me the title of the page at url 'https://huggingface.co/blog'?")

|

||||

|

||||

(...)

|

||||

'Hugging Face – Blog'

|

||||

```

|

||||

|

||||

如果有任何代码尝试执行非法操作,或者生成的代码出现常规 Python 错误,执行将停止。

|

||||

|

||||

> [!WARNING]

|

||||

> 在使用大语言模型(LLM)生成代码时,生成的代码会被执行,避免导入或使用任何不安全的库或模块。

|

||||

|

||||

### 系统提示

|

||||

|

||||

智能体,或者说驱动智能体的 LLM,根据系统提示生成输出。系统提示可以定制并根据目标任务进行调整。例如,检查 [`ReactCodeAgent`] 的系统提示(以下版本经过简化)。

|

||||

|

||||

```text

|

||||

You will be given a task to solve as best you can.

|

||||

You have access to the following tools:

|

||||

<<tool_descriptions>>

|

||||

|

||||

To solve the task, you must plan forward to proceed in a series of steps, in a cycle of 'Thought:', 'Code:', and 'Observation:' sequences.

|

||||

|

||||

At each step, in the 'Thought:' sequence, you should first explain your reasoning towards solving the task, then the tools that you want to use.

|

||||

Then in the 'Code:' sequence, you should write the code in simple Python. The code sequence must end with '/End code' sequence.

|

||||

During each intermediate step, you can use 'print()' to save whatever important information you will then need.

|

||||

These print outputs will then be available in the 'Observation:' field, for using this information as input for the next step.

|

||||

|

||||

In the end you have to return a final answer using the `final_answer` tool.

|

||||

|

||||

Here are a few examples using notional tools:

|

||||

---

|

||||

{examples}

|

||||

|

||||

Above example were using notional tools that might not exist for you. You only have acces to those tools:

|

||||

<<tool_names>>

|

||||

You also can perform computations in the python code you generate.

|

||||

|

||||

Always provide a 'Thought:' and a 'Code:\n```py' sequence ending with '```<end_code>' sequence. You MUST provide at least the 'Code:' sequence to move forward.

|

||||

|

||||

Remember to not perform too many operations in a single code block! You should split the task into intermediate code blocks.

|

||||

Print results at the end of each step to save the intermediate results. Then use final_answer() to return the final result.

|

||||

|

||||

Remember to make sure that variables you use are all defined.

|

||||

|

||||

Now Begin!

|

||||

```

|

||||

|

||||

系统提示包括:

|

||||

- 解释智能体应该如何工作以及工具的**介绍**。

|

||||

- 所有工具的描述由 `<<tool_descriptions>>` 标记在运行时动态替换,这样智能体就知道可以使用哪些工具及其用途。

|

||||

- 工具的描述来自工具的属性,`name`、`description`、`inputs` 和 `output_type`,以及一个简单的 `jinja2` 模板,您可以根据需要进行调整。

|

||||

- 期望的输出格式。

|

||||

|

||||

您可以通过向 `system_prompt` 参数传递自定义提示来最大程度地提高灵活性,从而覆盖整个系统提示模板。

|

||||

|

||||

```python

|

||||

from transformers import ReactJsonAgent

|

||||

from transformers.agents import PythonInterpreterTool

|

||||

|

||||

agent = ReactJsonAgent(tools=[PythonInterpreterTool()], system_prompt="{your_custom_prompt}")

|

||||

```

|

||||

|

||||

> [WARNING]

|

||||

> 必须在`template`中定义 `<<tool_descriptions>>` 这个变量,以便智能体能够正确地识别并使用可用的工具

|

||||

|

||||

|

||||

### 检查智能体的运行

|

||||

|

||||

以下是检查运行后发生了什么的一些有用属性:

|

||||

- `agent.logs` 存储了智能体的详细日志。每一步的所有内容都会存储在一个字典中,然后附加到 `agent.logs`。

|

||||

- 运行 `agent.write_inner_memory_from_logs()` 会从日志中创建智能体的内存,以便 LLM 查看,作为一系列聊天消息。此方法会遍历日志的每个步骤,只保存其感兴趣的消息:例如,它会单独保存系统提示和任务,然后为每个步骤保存 LLM 输出的消息,以及工具调用输出的消息。如果您想要更高层次的查看发生了什么,可以使用此方法 —— 但并不是每个日志都会被此方法转录。

|

||||

|

||||

## 工具

|

||||

|

||||

工具是智能体使用的基本功能。

|

||||

|

||||

例如,您可以检查 [`PythonInterpreterTool`]:它有一个名称、描述、输入描述、输出类型和 `__call__` 方法来执行该操作。

|

||||

|

||||

当智能体初始化时,工具属性会用来生成工具描述,然后将其嵌入到智能体的系统提示中,这让智能体知道可以使用哪些工具以及为什么使用它们。

|

||||

|

||||

### 默认工具箱

|

||||

|

||||

Transformers 提供了一个默认工具箱,用于增强智能体,您可以在初始化时通过 `add_base_tools=True` 参数将其添加到智能体中:

|

||||

|

||||

- **文档问答**:给定一个文档(如图像格式的 PDF),回答关于该文档的问题([Donut](./model_doc/donut))

|

||||

- **图像问答**:给定一张图片,回答关于该图像的问题([VILT](./model_doc/vilt))

|

||||

- **语音转文本**:给定一个人讲述的音频录音,将其转录为文本(Whisper)

|

||||

- **文本转语音**:将文本转换为语音([SpeechT5](./model_doc/speecht5))

|

||||

- **翻译**:将给定的句子从源语言翻译为目标语言

|

||||

- **DuckDuckGo 搜索**:使用 `DuckDuckGo` 浏览器进行网络搜索

|

||||

- **Python 代码解释器**:在安全环境中运行 LLM 生成的 Python 代码。只有在初始化 [`ReactJsonAgent`] 时将 `add_base_tools=True` 时,代码智能体才会添加此工具,因为基于代码的智能体已经能够原生执行 Python 代码

|

||||

|

||||

|

||||

您可以通过调用 [`load_tool`] 函数来手动使用某个工具并执行任务。

|

||||

|

||||

|

||||

```python

|

||||

from transformers import load_tool

|

||||

|

||||

tool = load_tool("text-to-speech")

|

||||

audio = tool("This is a text to speech tool")

|

||||

```

|

||||

|

||||

|

||||

### 创建新工具

|

||||

|

||||

您可以为 `Hugging Face` 默认工具无法涵盖的用例创建自己的工具。

|

||||

例如,假设我们要创建一个返回在 `Hugging Face Hub` 上某个任务中下载次数最多的模型的工具。

|

||||

|

||||

您将从以下代码开始:

|

||||

|

||||

```python

|

||||

from huggingface_hub import list_models

|

||||

|

||||

task = "text-classification"

|

||||

|

||||

model = next(iter(list_models(filter=task, sort="downloads", direction=-1)))

|

||||

print(model.id)

|

||||

```

|

||||

|

||||

这段代码可以很快转换为工具,只需将其包装成一个函数,并添加 `tool` 装饰器:

|

||||

|

||||

|

||||

```py

|

||||

from transformers import tool

|

||||

|

||||

@tool

|

||||

def model_download_tool(task: str) -> str:

|

||||

"""

|

||||

This is a tool that returns the most downloaded model of a given task on the Hugging Face Hub.

|

||||

It returns the name of the checkpoint.

|

||||

|

||||

Args:

|

||||

task: The task for which

|

||||

"""

|

||||

model = next(iter(list_models(filter="text-classification", sort="downloads", direction=-1)))

|

||||

return model.id

|

||||

```

|

||||

|

||||

该函数需要:

|

||||

- 一个清晰的名称。名称通常描述工具的功能。由于代码返回某个任务中下载次数最多的模型,因此我们将其命名为 `model_download_tool`。

|

||||

- 对输入和输出进行类型提示

|

||||

- 描述,其中包括 "`Args`:" 部分,描述每个参数(这次不需要类型指示,它会从类型提示中获取)。

|

||||

|

||||

所有这些将自动嵌入到智能体的系统提示中,因此请尽量使它们尽可能清晰!

|

||||

|

||||

> [TIP]

|

||||

> 这个定义格式与 apply_chat_template 中使用的工具模式相同,唯一的区别是添加了 tool 装饰器:可以在我们的工具使用 API 中[了解更多](https://huggingface.co/blog/unified-tool-use#passing-tools-to-a-chat-template).

|

||||

|

||||

然后,您可以直接初始化您的智能体:

|

||||

```py

|

||||

from transformers import CodeAgent

|

||||

agent = CodeAgent(tools=[model_download_tool], llm_engine=llm_engine)

|

||||

agent.run(

|

||||

"Can you give me the name of the model that has the most downloads in the 'text-to-video' task on the Hugging Face Hub?"

|

||||

)

|

||||

```

|

||||

|

||||

您将得到以下输出:

|

||||

```text

|

||||

======== New task ========

|

||||

Can you give me the name of the model that has the most downloads in the 'text-to-video' task on the Hugging Face Hub?

|

||||

==== Agent is executing the code below:

|

||||

most_downloaded_model = model_download_tool(task="text-to-video")

|

||||

print(f"The most downloaded model for the 'text-to-video' task is {most_downloaded_model}.")

|

||||

====

|

||||

```

|

||||

|

||||

输出:

|

||||

`"The most downloaded model for the 'text-to-video' task is ByteDance/AnimateDiff-Lightning."`

|

||||

|

||||

### 管理智能体的工具箱

|

||||

|

||||

如果您已经初始化了一个智能体,但想添加一个新的工具,重新初始化智能体会很麻烦。借助 Transformers,您可以通过添加或替换工具来管理智能体的工具箱。

|

||||

|

||||

让我们将 `model_download_tool` 添加到一个仅初始化了默认工具箱的现有智能体中。

|

||||

|

||||

```python

|

||||

from transformers import CodeAgent

|

||||

|

||||

agent = CodeAgent(tools=[], llm_engine=llm_engine, add_base_tools=True)

|

||||

agent.toolbox.add_tool(model_download_tool)

|

||||

```

|

||||

现在,我们可以同时使用新工具和之前的文本到语音工具:

|

||||

|

||||

```python

|

||||

agent.run(

|

||||

"Can you read out loud the name of the model that has the most downloads in the 'text-to-video' task on the Hugging Face Hub and return the audio?"

|

||||

)

|

||||

```

|

||||

|

||||

|

||||

| **Audio** |

|

||||

|------------------------------------------------------------------------------------------------------------------------------------------------------|

|

||||

| <audio controls><source src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/damo.wav" type="audio/wav"/> |

|

||||

|

||||

|

||||

> [WARNING]

|

||||

> 当向一个已经运行良好的代理添加工具时要小心,因为这可能会导致选择偏向你的工具,或者选择已经定义的工具之外的其他工具。

|

||||

|

||||

|

||||

使用 agent.toolbox.update_tool() 方法可以替换智能体工具箱中的现有工具。

|

||||

如果您的新工具完全替代了现有工具,这非常有用,因为智能体已经知道如何执行该特定任务。

|

||||

只需确保新工具遵循与替换工具相同的 API,或者调整系统提示模板,以确保所有使用替换工具的示例都得到更新。

|

||||

|

||||

|

||||

### 使用工具集合

|

||||

|

||||

您可以通过使用 ToolCollection 对象来利用工具集合,指定您想要使用的工具集合的 slug。

|

||||

然后将这些工具作为列表传递给智能体进行初始化,并开始使用它们!

|

||||

|

||||

```py

|

||||

from transformers import ToolCollection, ReactCodeAgent

|

||||

|

||||

image_tool_collection = ToolCollection(collection_slug="huggingface-tools/diffusion-tools-6630bb19a942c2306a2cdb6f")

|

||||

agent = ReactCodeAgent(tools=[*image_tool_collection.tools], add_base_tools=True)

|

||||

|

||||

agent.run("Please draw me a picture of rivers and lakes.")

|

||||

```

|

||||

|

||||

为了加速启动,工具仅在智能体调用时加载。

|

||||

|

||||

这将生成如下图像:

|

||||

|

||||

<img src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/rivers_and_lakes.png">

|

||||

@ -1,285 +0,0 @@

|

||||

<!--Copyright 2023 The HuggingFace Team. All rights reserved.

|

||||

|

||||

Licensed under the Apache License, Version 2.0 (the "License"); you may not use this file except in compliance with

|

||||

the License. You may obtain a copy of the License at

|

||||

|

||||

http://www.apache.org/licenses/LICENSE-2.0

|

||||

|

||||

Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on

|

||||

an "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the

|

||||

specific language governing permissions and limitations under the License.

|

||||

|

||||

⚠️ Note that this file is in Markdown but contain specific syntax for our doc-builder (similar to MDX) that may not be

|

||||

rendered properly in your Markdown viewer.

|

||||

|

||||

-->

|

||||

|

||||

# Transformers Agents

|

||||

|

||||

<Tip warning={true}>

|

||||

|

||||

`Transformers Agents`是一个实验性的随时可能发生变化的API。由于API或底层模型可能发生变化,`agents`返回的结果也会有所不同。

|

||||

|

||||

</Tip>

|

||||

|

||||

Transformers版本`v4.29.0`基于`tools`和`agents`概念构建。您可以在[此Colab链接](https://colab.research.google.com/drive/1c7MHD-T1forUPGcC_jlwsIptOzpG3hSj)中进行测试。

|

||||

|

||||

简而言之,它在`Transformers`之上提供了一个自然语言API:我们定义了一组经过筛选的`tools`,并设计了一个`agents`来解读自然语言并使用这些工具。它具有很强的可扩展性;我们筛选了一些相关的`tools`,但我们将向您展示如何通过社区开发的`tool`轻松地扩展系统。

|

||||

|

||||

让我们从一些可以通过这个新API实现的示例开始。在处理多模态任务时它尤其强大,因此让我们快速试着生成图像并大声朗读文本。

|

||||

|

||||

|

||||

```py

|

||||

agent.run("Caption the following image", image=image)

|

||||

```

|

||||

|

||||

| **输入** | **输出** |

|

||||

|-----------------------------------------------------------------------------------------------------------------------------|-----------------------------------|

|

||||

| <img src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/beaver.png" width=200> | A beaver is swimming in the water |

|

||||

|

||||

---

|

||||

|

||||

```py

|

||||

agent.run("Read the following text out loud", text=text)

|

||||

```

|

||||

| **输入** | **输出** |

|

||||

|-----------------------------------|----------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------|

|

||||

| A beaver is swimming in the water | <audio controls><source src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/tts_example.wav" type="audio/wav"> your browser does not support the audio element. </audio>

|

||||

|

||||

---

|

||||

|

||||

```py

|

||||

agent.run(

|

||||

"In the following `document`, where will the TRRF Scientific Advisory Council Meeting take place?",

|

||||

document=document,

|

||||

)

|

||||

```

|

||||

| **输入** | **输出** |

|

||||

|-----------------------------------------------------------------------------------------------------------------------------|----------------|

|

||||

| <img src="https://datasets-server.huggingface.co/assets/hf-internal-testing/example-documents/--/hf-internal-testing--example-documents/test/0/image/image.jpg" width=200> | ballroom foyer |

|

||||

|

||||

## 快速入门

|

||||

|

||||

要使用 `agent.run`,您需要实例化一个`agent`,它是一个大型语言模型(LLM)。我们支持OpenAI模型以及来自BigCode和OpenAssistant的开源替代方案。OpenAI模型性能更好(但需要您拥有OpenAI API密钥,因此无法免费使用),Hugging Face为BigCode和OpenAssistant模型提供了免费访问端点。

|

||||

|

||||

一开始请安装`agents`附加模块,以安装所有默认依赖项。

|

||||

|

||||

```bash

|

||||

pip install transformers[agents]

|

||||

```

|

||||

|

||||

要使用OpenAI模型,您可以在安装`openai`依赖项后实例化一个`OpenAiAgent`:

|

||||

|

||||

```bash

|

||||

pip install openai

|

||||

```

|

||||

|

||||

|

||||

```py

|

||||

from transformers import OpenAiAgent

|

||||

|

||||

agent = OpenAiAgent(model="text-davinci-003", api_key="<your_api_key>")

|

||||

```

|

||||

|

||||

要使用BigCode或OpenAssistant,请首先登录以访问Inference API:

|

||||

|

||||

```py

|

||||

from huggingface_hub import login

|

||||

|

||||

login("<YOUR_TOKEN>")

|

||||

```

|

||||

|

||||

然后,实例化`agent`:

|

||||

|

||||

```py

|

||||

from transformers import HfAgent

|

||||

|

||||

# Starcoder

|

||||

agent = HfAgent("https://api-inference.huggingface.co/models/bigcode/starcoder")

|

||||

# StarcoderBase

|

||||

# agent = HfAgent("https://api-inference.huggingface.co/models/bigcode/starcoderbase")

|

||||

# OpenAssistant

|

||||

# agent = HfAgent(url_endpoint="https://api-inference.huggingface.co/models/OpenAssistant/oasst-sft-4-pythia-12b-epoch-3.5")

|

||||

```

|

||||

|

||||

此示例使用了目前Hugging Face免费提供的推理API。如果你有自己的推理端点用于此模型(或其他模型),你可以用你的URL替换上面的URL。

|

||||

|

||||

<Tip>

|

||||

|

||||

StarCoder和OpenAssistant可以免费使用,并且在简单任务上表现出色。然而,当处理更复杂的提示时就不再有效。如果你遇到这样的问题,我们建议尝试使用OpenAI模型,尽管遗憾的是它不是开源的,但它在目前情况下表现更好。

|

||||

|

||||

</Tip>

|

||||

|

||||

现在,您已经可以开始使用了!让我们深入了解您现在可以使用的两个API。

|

||||

|

||||

### 单次执行(run)

|

||||

|

||||

单次执行方法是使用`agent`的 `~Agent.run`:

|

||||

|

||||

```py

|

||||

agent.run("Draw me a picture of rivers and lakes.")

|

||||

```

|

||||

|

||||

<img src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/rivers_and_lakes.png" width=200>

|

||||

|

||||

它会自动选择适合您要执行的任务的`tool`(或`tools`),并以适当的方式运行它们。它可以在同一指令中执行一个或多个任务(尽管您的指令越复杂,`agent`失败的可能性就越大)。

|

||||

|

||||

|

||||

```py

|

||||

agent.run("Draw me a picture of the sea then transform the picture to add an island")

|

||||

```

|

||||

|

||||

<img src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/sea_and_island.png" width=200>

|

||||

|

||||

<br/>

|

||||

|

||||

每个 [`~Agent.run`] 操作都是独立的,因此您可以多次连续运行 [`~Agent.run`]并执行不同的任务。

|

||||

|

||||

请注意,您的 `agent` 只是一个大型语言模型,因此您略有变化的提示可能会产生完全不同的结果。重要的是尽可能清晰地解释您要执行的任务。我们在[这里](../en/custom_tools#writing-good-user-inputs)更深入地讨论了如何编写良好的提示。

|

||||

|

||||

如果您想在多次执行之间保持同一状态或向`agent`传递非文本对象,可以通过指定`agent`要使用的变量来实现。例如,您可以生成有关河流和湖泊的第一幅图像,并要求模型通过执行以下操作向该图片添加一个岛屿:

|

||||

|

||||

```python

|

||||

picture = agent.run("Generate a picture of rivers and lakes.")

|

||||

updated_picture = agent.run("Transform the image in `picture` to add an island to it.", picture=picture)

|

||||

```

|

||||

|

||||

<Tip>

|

||||

|

||||

当模型无法理解您的请求和库中的工具时,这可能会有所帮助。例如:

|

||||

|

||||

```py

|

||||

agent.run("Draw me the picture of a capybara swimming in the sea")

|

||||

```

|

||||

|

||||

在这种情况下,模型可以以两种方式理解您的请求:

|

||||

- 使用`text-to-image` 生成在大海中游泳的大水獭

|

||||

- 或者,使用`text-to-image`生成大水獭,然后使用`image-transformation`工具使其在大海中游泳

|

||||

|

||||

如果您想强制使用第一种情景,可以通过将提示作为参数传递给它来实现:

|

||||

|

||||

|

||||

```py

|

||||

agent.run("Draw me a picture of the `prompt`", prompt="a capybara swimming in the sea")

|

||||

```

|

||||

|

||||

</Tip>

|

||||

|

||||

|

||||

### 基于交流的执行 (chat)

|

||||

|

||||

基于交流的执行(chat)方式是使用 [`~Agent.chat`]:

|

||||

|

||||

```py

|

||||

agent.chat("Generate a picture of rivers and lakes")

|

||||

```

|

||||

|

||||

<img src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/rivers_and_lakes.png" width=200>

|

||||

|

||||

```py

|

||||

agent.chat("Transform the picture so that there is a rock in there")

|

||||

```

|

||||

|

||||

<img src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/rivers_and_lakes_and_beaver.png" width=200>

|

||||

|

||||

<br/>

|

||||

|

||||

当您希望在不同指令之间保持同一状态时,这会是一个有趣的方法。它更适合用于单个指令,而不是复杂的多步指令(`~Agent.run` 方法更适合处理这种情况)。

|

||||

|

||||

这种方法也可以接受参数,以便您可以传递非文本类型或特定提示。

|

||||

|

||||

### ⚠️ 远程执行

|

||||

|

||||

出于演示目的以便适用于所有设置,我们为发布版本的少数默认工具创建了远程执行器。这些工具是使用推理终端(inference endpoints)创建的。

|

||||

|

||||

目前我们已将其关闭,但为了了解如何自行设置远程执行器工具,我们建议阅读[自定义工具指南](./custom_tools)。

|

||||

|

||||

### 这里发生了什么?什么是`tools`,什么是`agents`?

|

||||

|

||||

|

||||

<img src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/diagram.png">

|

||||

|

||||

|

||||

#### Agents

|

||||

|

||||

这里的`Agents`是一个大型语言模型,我们通过提示它以访问特定的工具集。

|

||||

|

||||

大型语言模型在生成小代码示例方面表现出色,因此这个API利用这一特点,通过提示LLM生成一个使用`tools`集合的小代码示例。然后,根据您给`Agents`的任务和`tools`的描述来完成此提示。这种方式让它能够访问工具的文档,特别是它们的期望输入和输出,以生成相关的代码。

|

||||

|

||||

#### Tools

|

||||

|

||||

`Tools`非常简单:它们是有名称和描述的单个函数。然后,我们使用这些`tools`的描述来提示代理。通过提示,我们向`agent`展示如何使用`tool`来执行查询语言中请求的操作。

|

||||

|

||||

这是使用全新`tools`而不是`pipelines`,因为`agent`编写的代码更好,具有非常原子化的`tools`。`pipelines`经常被重构,并且通常将多个任务合并为一个。`tools`旨在专注于一个非常简单的任务。

|

||||

|

||||

#### 代码执行?

|

||||

|

||||

然后,这段代码基于`tools`的输入被我们的小型Python解释器执行。我们听到你在后面大声呼喊“任意代码执行!”,但让我们解释为什么情况并非如此。

|

||||

|

||||

只能您提供的`tools`和打印函数可以被执行,因此您已经受到了执行的限制。如果仅限于 Hugging Face 工具,那么您应该是安全的。

|

||||

|

||||

然后,我们不允许任何属性查找或导入(无论如何都不需要将输入/输出传递给一小组函数),因此所有最明显的攻击(并且您需要提示LLM无论如何输出它们)不应该是一个问题。如果你想超级安全,你可以使用附加参数 return_code=True 执行 run() 方法,在这种情况下,`agent`将只返回要执行的代码,你可以决定是否执行。

|

||||

|

||||

如果`agent`生成的代码存在任何尝试执行非法操作的行为,或者代码中出现了常规Python错误,执行将停止。

|

||||

|

||||

|

||||

### 一组经过精心筛选的`tools`

|

||||

|

||||

我们确定了一组可以赋予这些`agent`强大能力的`tools`。以下是我们在`transformers`中集成的`tools`的更新列表:

|

||||

|

||||

- **文档问答**:给定一个图像格式的文档(例如PDF),回答该文档上的问题([Donut](../en/model_doc/donut))

|

||||

- **文本问答**:给定一段长文本和一个问题,回答文本中的问题([Flan-T5](../en/model_doc/flan-t5))

|

||||

- **无条件图像字幕**:为图像添加字幕!([BLIP](../en/model_doc/blip))

|

||||

- **图像问答**:给定一张图像,回答该图像上的问题([VILT](../en/model_doc/vilt))

|

||||

- **图像分割**:给定一张图像和一个提示,输出该提示的分割掩模([CLIPSeg](../en/model_doc/clipseg))

|

||||

- **语音转文本**:给定一个人说话的音频录音,将演讲内容转录为文本([Whisper](../en/model_doc/whisper))

|

||||

- **文本转语音**:将文本转换为语音([SpeechT5](../en/model_doc/speecht5))

|

||||

- **Zero-Shot文本分类**:给定一个文本和一个标签列表,确定文本最符合哪个标签([BART](../en/model_doc/bart))

|

||||

- **文本摘要**:总结长文本为一两句话([BART](../en/model_doc/bart))

|

||||

- **翻译**:将文本翻译为指定语言([NLLB](../en/model_doc/nllb))

|

||||

|

||||

这些`tools`已在transformers中集成,并且也可以手动使用,例如:

|

||||

|

||||

```py

|

||||

from transformers import load_tool

|

||||

|

||||

tool = load_tool("text-to-speech")

|

||||

audio = tool("This is a text to speech tool")

|

||||

```

|

||||

|

||||

### 自定义工具

|

||||

|

||||

尽管我们确定了一组经过筛选的`tools`,但我们坚信,此实现提供的主要价值在于能够快速创建和共享自定义`tool`。

|

||||

|

||||

通过将工具的代码上传到Hugging Face空间或模型repository,您可以直接通过`agent`使用`tools`。我们已经添加了一些**与transformers无关**的`tools`到[`huggingface-tools`组织](https://huggingface.co/huggingface-tools)中:

|

||||

|

||||

- **文本下载器**:从Web URL下载文本

|

||||

- **文本到图像**:根据提示生成图像,利用`stable diffusion`

|

||||

- **图像转换**:根据初始图像和提示修改图像,利用`instruct pix2pix stable diffusion`

|

||||

- **文本到视频**:根据提示生成小视频,利用`damo-vilab`

|

||||

|

||||

从一开始就一直在使用的文本到图像`tool`是一个远程`tool `,位于[*huggingface-tools/text-to-image*](https://huggingface.co/spaces/huggingface-tools/text-to-image)!我们将继续在此组织和其他组织上发布此类`tool`,以进一步增强此实现。

|

||||

|

||||

`agents`默认可以访问存储在[`huggingface-tools`](https://huggingface.co/huggingface-tools)上的`tools`。我们将在后续指南中解释如何编写和共享自定义`tools`,以及如何利用Hub上存在的任何自定义`tools`。

|

||||

|

||||

### 代码生成

|

||||

|

||||

到目前为止,我们已经展示了如何使用`agents`来为您执行操作。但是,`agents`仅使用非常受限Python解释器执行的代码。如果您希望在不同的环境中使用生成的代码,可以提示`agents`返回代码,以及`tools`的定义和准确的导入信息。

|

||||

|

||||

例如,以下指令

|

||||

|

||||

```python

|

||||

agent.run("Draw me a picture of rivers and lakes", return_code=True)

|

||||

```

|

||||

|

||||

返回以下代码

|

||||

|

||||

```python

|

||||

from transformers import load_tool

|

||||

|

||||

image_generator = load_tool("huggingface-tools/text-to-image")

|

||||

|

||||

image = image_generator(prompt="rivers and lakes")

|

||||

```

|

||||

|

||||

然后你就可以调整并执行代码

|

||||

Loading…

Reference in New Issue

Block a user